Flight Simulator 2020 Top oder Flop? Review [Kommentar]

Nach dem Hype um den Flight Simulator 2020, den man in den letzten Tagen auf diversen Internetseiten gefunden hat, musste man meinen man verpasst das Spiel (pardon Simulation, ach was im Store nennt Microsoft es selbst Spiel, somit bleibe ich dabei) des Jahrhunderts, wenn man ihn nicht hat.

Gerade in Zeiten von Corona, wo das Reisen doch arg eingeschränkt ist oder man es den Unbelehrbaren überlässt die Infektionszahlen wieder deutlich nach oben zu treiben, reizt es natürlich sehr sich virtuell durch die Welt zu bewegen. Da ich zusätzlich auch noch Urlaub habe konnte auch ich mich nicht beherrschen.

Flight Simulator 2020 – High Sierras

Normalerweise kaufe ich keine Vollpreisspiele mehr, sondern warte ein paar Jahre bis sie deutlich günstiger und mit Patches versehen sind. So ändern sich die Zeiten. Beim FS 2020 hat die Neugierde aber gesiegt.

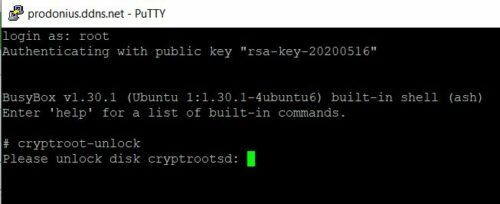

Der Weg ein langer zum FS 2020 es ist hätte Joda wohl gesagt

War es das Wert? Bedingt.

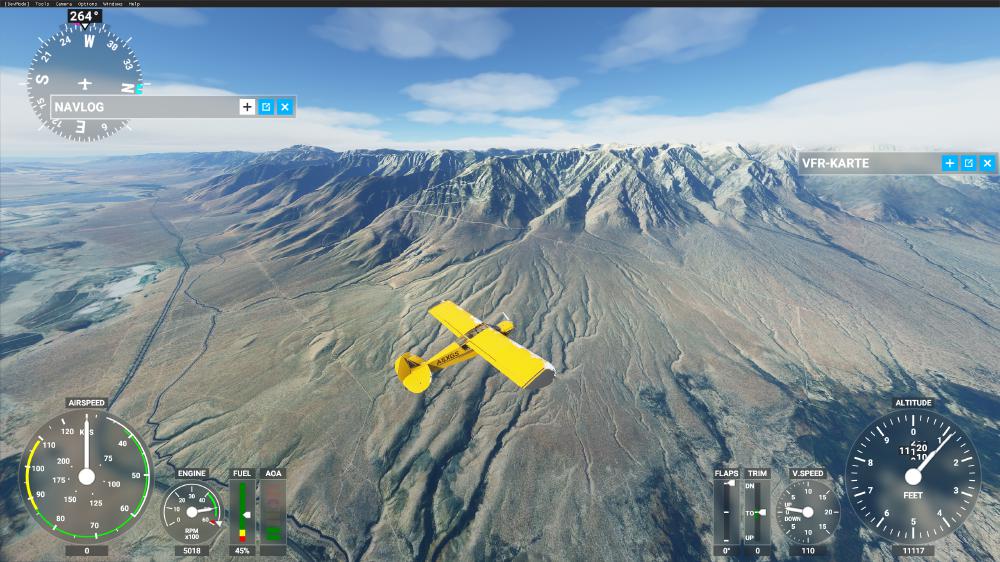

Flight Simulator 2020 – High Sierras

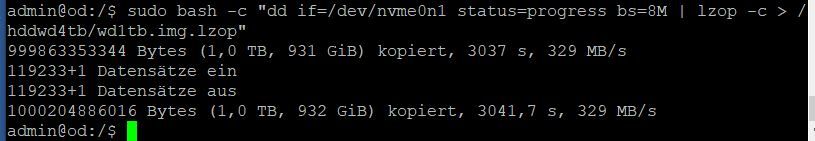

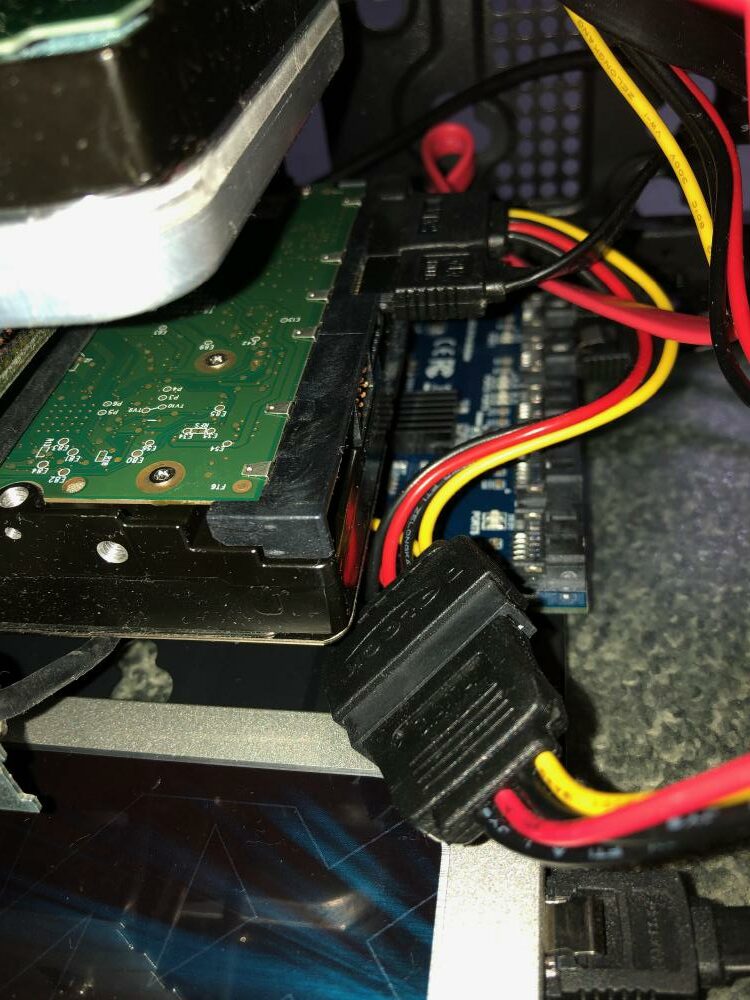

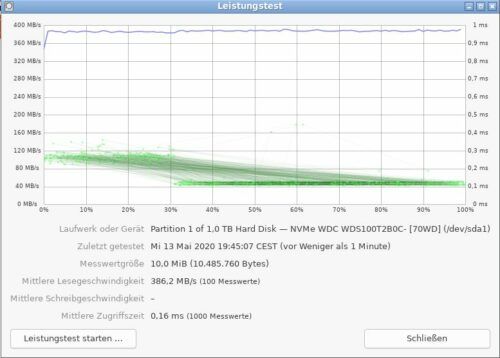

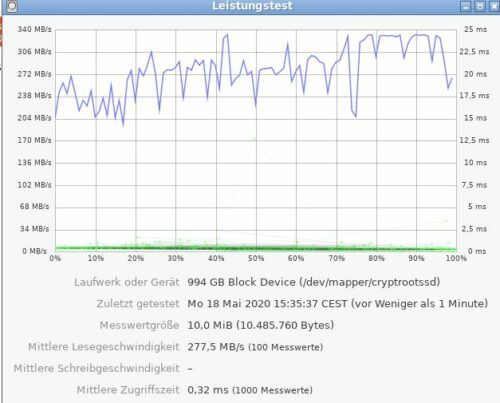

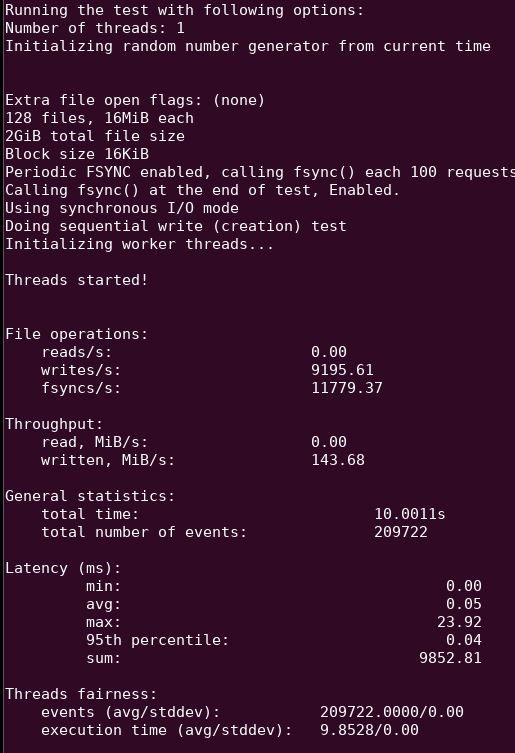

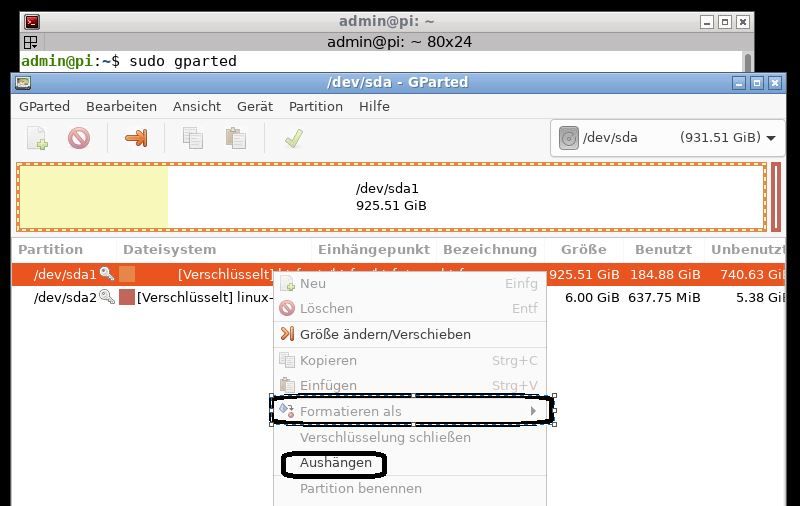

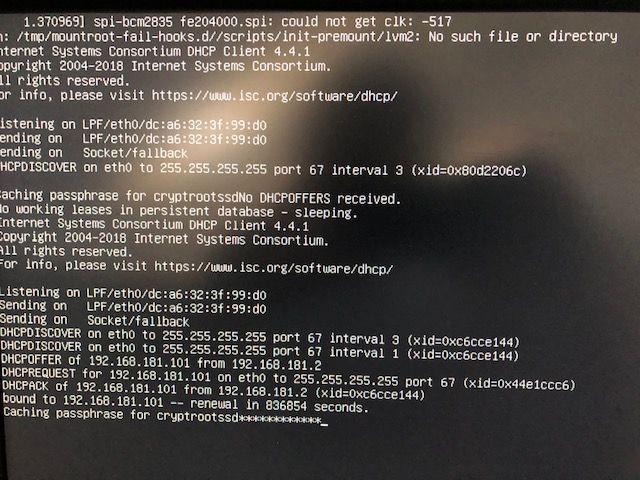

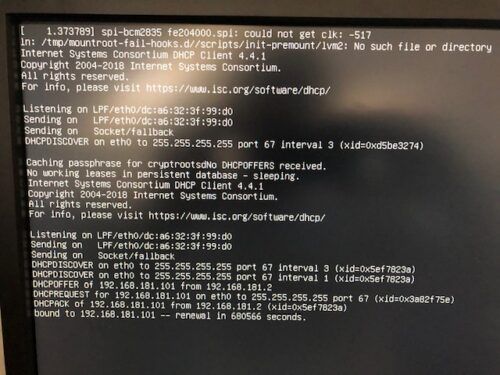

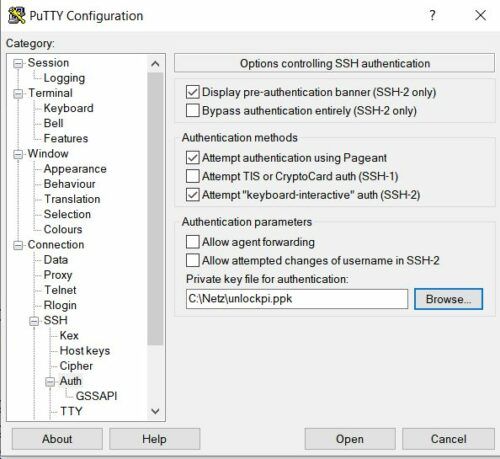

Zuerst mal ist die Größe des Spiels beachtlich. Für die Installation werden ca. 130GB benötigt (bitte auf SSD, sonst hat man graue Haare, bevor das Spiel geladen wurde). Ich hatte die DVD Version bestellt, wo man erst mal zum Disc Jockey wird. Ganze 10 DVDs bekommt man in dem Paket.

Problem eins: Im Notebook hatte ich kein DVD Laufwerk, optische Laufwerke hat man ja heute kaum noch. Also erst mal 10 DVDs zu Images verarbeiten, dann die Images vom einen Rechner auf den anderen Kopieren und dann noch installieren. Da ist man schnell mal drei Stunden älter.

Flight Simulator 2020 – Mount Whitney Bereich

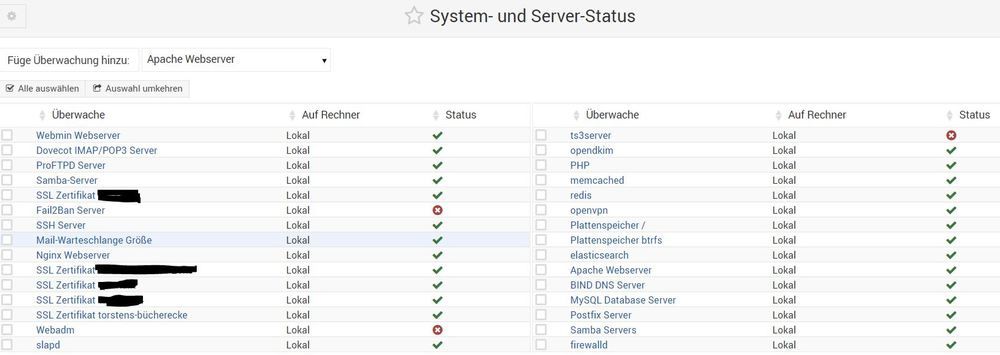

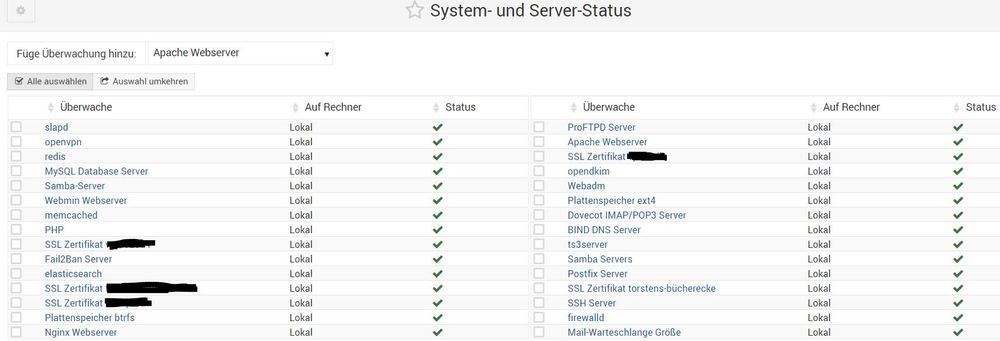

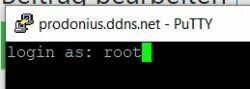

Wenn man dann die Installation beendet hat, steht man erst mal etwas ratlos da. Denn installiert danach ist kein funktionsfähiges Programm, sondern nur die Weltdaten. Zusätzlich muss man noch die App auf dem Microsoft App Store installieren, also muss man zwangsweise erst mal eine Registrierung bei Microsoft durchführen. Danach wird dann zwangsweise noch ein XBox whatever Konto erstellt und dann darf man theoretisch downloaden.

Nicht so auf meinem Notebook. Dort kam nur die Meldung, dass aktuell ein Problem bei Microsoft vorliegt und ich es später versuchen soll. Ich dachte mir schon, dass das nichts temporäres ist und das die Fehlermeldung irreführend ist. Man kennt ja Microsoft so langsam…

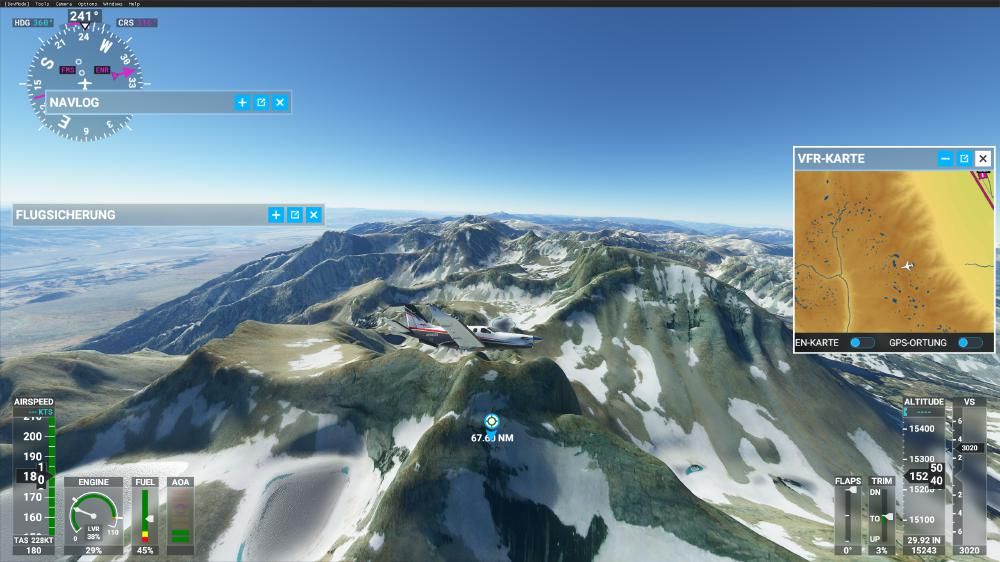

Flight Simulator 2020 – Mount Whitney Bereich

Die Lösung war die Installation der neusten Windows Version (auf dem Notebook war 1909 installiert, also locker neu genug lt. FS Voraussetzungsliste). Das Installieren der aktuellen Windows Version ging natürlich auch nicht problemlos. Erst mal gab es zwei Fehlversuche beim Upgrade bis es gelungen ist (für alle die es interessiert ich habe danach sämtliche alte Hardware im abgesicherten Modus entfernt und die Systemdatein per Kommando reparieren lassen), das waren glaube ich in Summe noch mal rund 5 Stunden und juchu danach ließ sich die App sogar installieren (ca. 1GB).

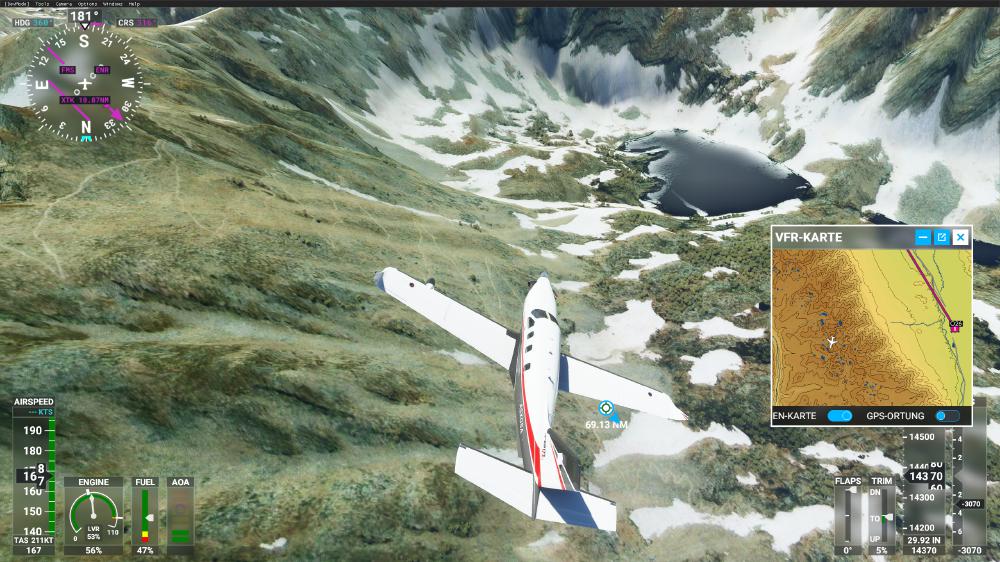

Flight Simulator 2020 – Mount Whitney

Anschließend stehen natürlich direkt mal 16GB Patches bereit (und das direkt in Version 1 – in einem Jahr darf man dann wahrscheinlich gleich 100GB neu laden).

Ihr merkt also schon – eine gute Internetverbindung ist Pflicht, auch aus anderen Gründen, wie man später noch erkennt.

Der erste Sturzflug

Zuerst habe ich für eine schnelle Proberunde versucht mit Maus und Tastatur zu spielen. OMG. Mehr gibt es dazu nicht zu sagen. In einem Review stand, dass sich das Spiel mit Maus und Tastatur recht gut spielt. Das kann ich so nicht bestätigen. Das kann nur Wunschdenken gewesen sein. Ich bin nicht mal von der Landebahn weggekommen, da hatte ich den Flieger schon versenkt.

FS 2020 – Angebliche Schutzhütte auf Mount Whitney (da steht eine aber die sieht etwas anders aus)

Flight Simulator 2020 – Mount Whitney

Zu Vergleichszwecken die Realität, die leider von Fotos auch nur unzureichend eingefangen wird (alles was oben grün ist sind blanker Fels und auch deutlich steiler als oben dargestellt und mit viel mehr Konturen):

Mount Whitney (der linke Teil von den beiden Seen entspricht dem oberen)

Mount Whitney

Mount Whitney

Also habe ich den Thrustmaster HOTAS entstaubt und angeschlossen und siehe da, easy going. Fliegen kann so einfach sein. Den Thrustmaster hatte ich eigentlich mal für Star Citzen gekauft. Das ein paar Jahre später den FS 2020 damit spiele noch bevor Star Citizen erscheint war auch nicht geplant. Die 4 Buttons und 4 Mehrwegeschalter (4-8 Wege je Schalter) bekommt man übrigens selbst mit einem Kleinflugzeug problemlos belegt.

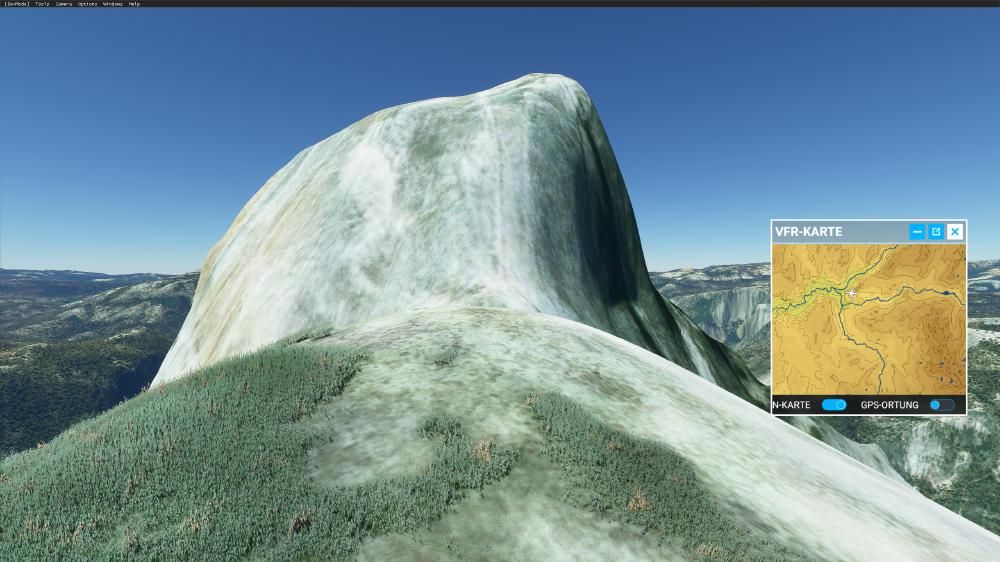

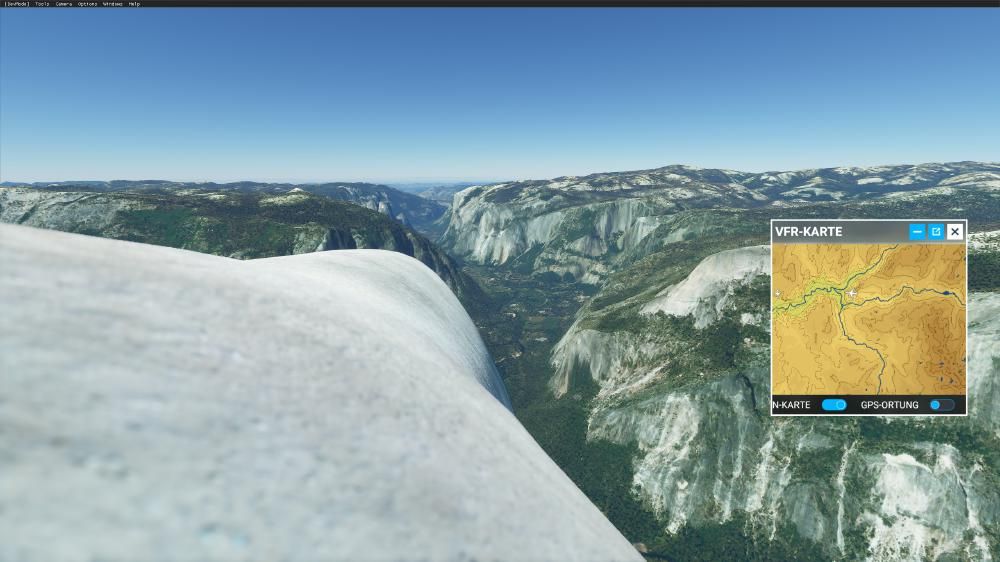

Flight Simulator 2020 – Yosemite Valley?

Nach längerem Suchen bin ich dann doch noch fündig geworden (die Dronencam war die Lösung – die Dronencam erlaubt Bewegungen unabhängig vom Flugzeug und mit beliebiger Geschwindigkeit):

FS 2020 – Half Dome Rückseite

Half Dome Rückseite Original

FS 2020 – Yosemite Valley

Original Yosemite Valley

FS 2020 – Weichspülen von Bergen

Yosemite Valley Original

Ok, dann ab in die Flugschule und mit dem HOTAS (Hands on Throttle and Stick, wobei ich nur den Stick habe) spielen sich alle Flugmanöver sehr einfach, Start, Landen, Navigieren, alles kein Ding. Lediglich Seitenruderpedale wären noch hilfreich aber mit dem Thrustmaster und der Target Software bekommt man die Achse auch recht gut über Tasten abgebildet.

Ab in die Sierras

Nachdem ich die Flugschule durch hatte war ich heiß wieder in die High Serras zu kommen. Nach meinem PCT Besuch werde ich von den Sierras wohl nie wieder los kommen.

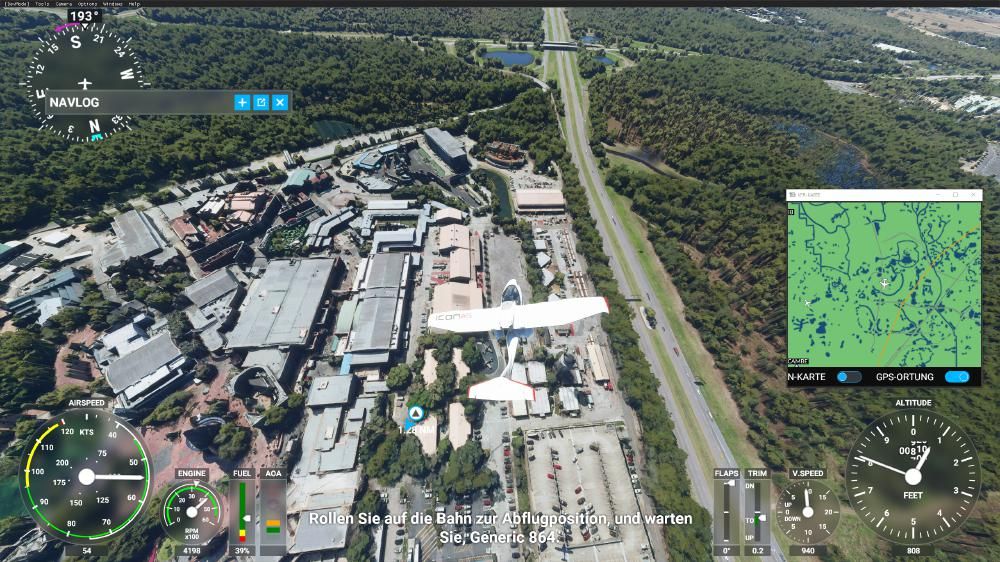

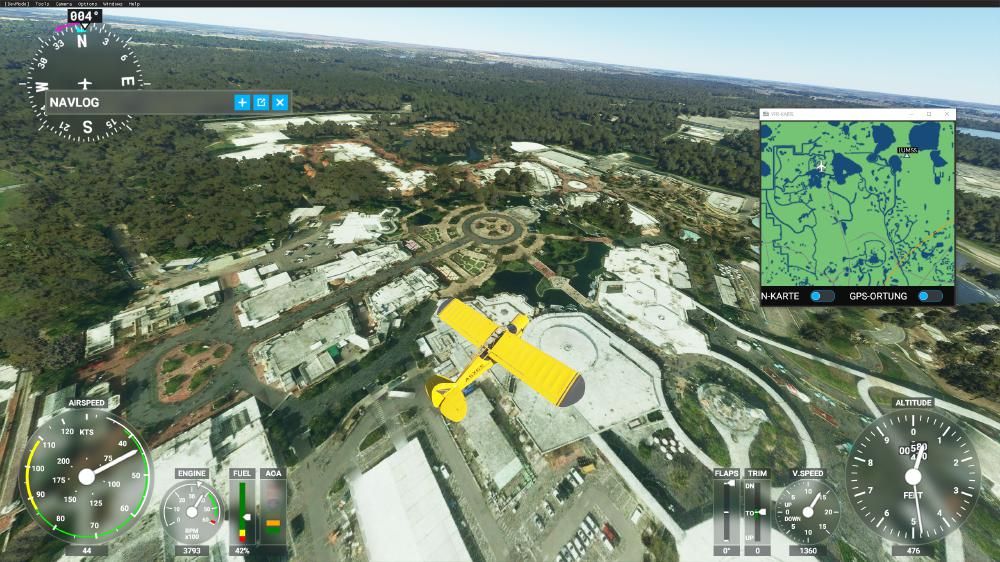

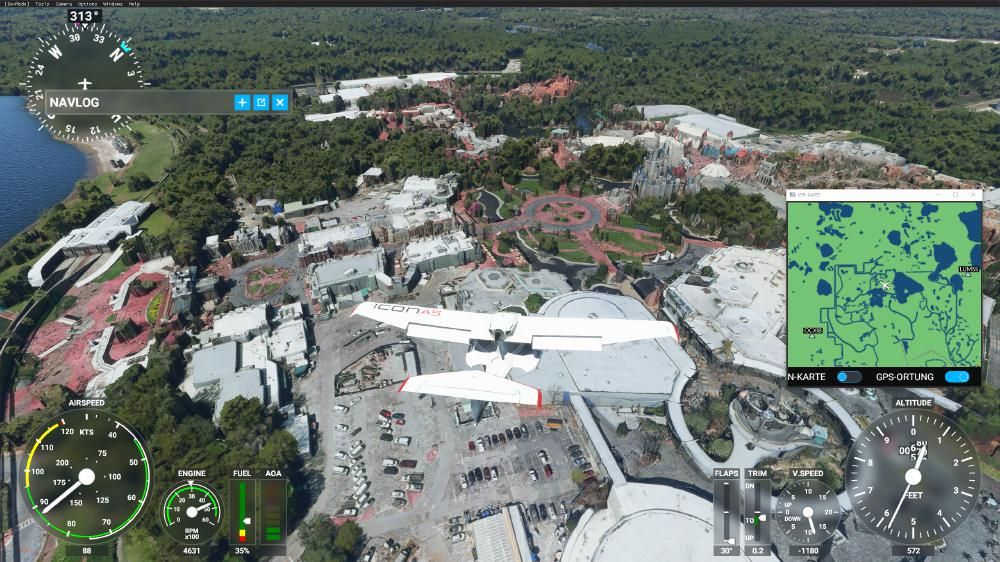

Flight Simulator 2020 – Epcot von oben mit 3D Modellen (nicht zu Tief gehen, dann sieht es klasse aus)

Nach dem Start in Lone Pine bin ich zuerst beeindruckt, sogar auf dem “Flughafen” irgendwo im nirgendwo sind Gebäude vorhanden, sogar mit Satellitenschüsseln auf dem 3D Modell. Der Anflug auf die Sierras lässt erste Ernüchterung aufkommen. Vom Fotorealismus, den einige Reviewer hinaus beschwören ist selbst in der Ultra Stufe rein gar nichts zu sehen.

Flight Simulator 2020 – Gelandet in Epcot – eher hässlich

Die ersten 3 Anläufe in die High Sierras zu fliegen sind an der Wahl des Flugzeugs gescheitert. 14500 Fuß sind offenbar eine Hausnummer. Schon beeindruckend, was der menschliche Körper so alles leisten kann, wenn nicht mal Flugzeuge für mehrere hundert tausend Dollar oder sogar im Millionenbereich dort ankommen.

Auch wenn die Flugzeuge eine Reiseflughöhe von bis zu 20.000 Fuß hatten sind sie alle kläglich gescheitert. Es wird also nicht nur bei Autos das Blaue vom Himmel versprochen. Klar, wenn man den Copiloten rausschmeißt, den Tank leer macht und die richtigen Windverhältnisse hat, dann kommt man ggf. auf die Höhe. Ggf. hätte ich auch das Gemisch noch anders einstellen können, die Idee ist mir aber erst später gekommen (dazu verliert die Flugschule natürlich auch kein Wort, genauso wie zum Autopiloten usw.).

Flight Simulator 2020 – Hollywood Studios – Toy Story fehlt, Star Wars fehlt, der Disney Hut ist noch vorhanden – veraltet um mindestens 3 Jahre

Mein Ziel war der Mount Whitney (der höchste Berg von den USA abseits von Alaska), den ich letzte Jahr erklettert hatte (zumindest fast bist oben, ein paar hundert Fuß fehlten noch, bevor mich die Übelkeit befiel – Höhenkrankheit, überanstrengt oder ggf. was anderes).

Ich habe mich übrigens direkt noch mal geärgert als ich nun im FS gesehen habe wo ich abgebrochen habe. Ich war vielleicht noch 500m vom Gipfel weg. 🙁 Vor Ort war das leider keineswegs so gut ersichtlich. Derartige Analysen gehen mit dem FS 2020 übrigens super. Mehr dazu auch im Grand Canyon.

Mit dem 4. Flugzeug (reichlich overpowered aber noch ohne Turbine) ging es dann endlich zum Whitney – auch das war recht ernüchternd. Auch wenn man zumindest den Zig Zag Weg hinauf erkennt, ist von der Schönheit der Landschaft rein gar nichts zu sehen.

Bei Mount Whitney lässt sich aufgrund des Sees und des Aufstiegsweges aber recht leicht erkennen, das ich an der richtigen Position ist. Es gibt bei Mount Whitney zwar auch kein gutes Modell der Schutzhütte auf dem Gipfel (da steht ein Haus aber mit Satellitenschüssel – das entspricht nicht ganz der Wahrheit), aber immerhin lässt sich die Position recht gut bestimmen. Das Konzept setzt sich überall fort wo keine manuellen eingriffe erfolgen, wenn ich das richtig sehe. Wer zum Beispiel das eigene Haus sucht wird feststellen, dass der Grundriss zwar dem Original entspricht aber die komplette Textur, Fenster, Türen, Treppen sind frei erfunden. Das dürfte für 99% der Gebäude im FS 2020 zutreffen. Gebäude wie zum Beispiel in Disney und Vegas sind manuell Designt, wenn sie realistisch aussehen. Bei Disney trifft das aber auch nur auf markante Strukturen zu (beispielsweise der World Show Case – mal mit mehr oder weniger Sorgfalt – oder die Epcot Weltkugel, nicht aber die Mainstreet.

Flight Simulator 2020 – Epcot Testtrack und ein Teil vom World Showcase und Mexiko (das Gebäude unten – schon witzig, wenn man mal im Park war und wie beeindruckend das von vorne aussieht und wie simpel die Halle dahinter von oben aussieht), dahinter Norwegen und China

Bei Mount Whitney sind die Farben teilweise falsch und die Berge arg weichgespült (abgerundet). Somit wirkt die Darstellung nicht wirklich echt. Wegen der teilweise falschen Texturfarben stellt sich die Frage, ob wirklich alles auf Satellitenaufnahmen basiert, oder zum Teil generiert ist.

Die Höheninformationen scheinen nur in den Eckdaten zu passen. D.h. ich gehe davon aus, dass die Informationen eher Höhenlinien einer Karte entnommen wurden und nicht die realen Konturen abbilden.

Am eigenen Haus (das zu finden hat mich ganze 5 Minuten gekostet, da wir einen kleinen Flugplatz im Ort haben) lässt sich auch gut nachvollziehen, dass eben nicht überall Satellitenaufnahmen benutzt werden, wie ich schon in den Sierras vermutet habe. Ganze Wege neben Gebäuden sind um unser Haus einfach Grünflächen (das sind keine offiziellen Wege), Bäume stehen überall ums Haus, obwohl kein einziger da steht.

D.h. die komplette Textur ist um unser Haus generiert und hat nichts mit Satellitenaufnahmen zu tun (oder die generierten Grasflächen / Bäume / Sträucher überblenden in dem Fall einfach die Satellitenaufnahme). Auch der Baum und Strauchbewuchs ist generiert. Die hässlichen Bäume und Sträucher (siehe Epcot oder Florida Keys), die wie Felsen aussehen, findet man dort, wo sie nicht generiert wurden. Dort ist dann die Basis scheinbar eine Satellitenaufnahme.

Das Haus ist abseits der Grundrisses frei erfunden, das gilt auch für alle umstehenden.

Somit mussten die Entwickler sich offenbar zwischen Pest und Cholera entscheiden. Satellitenaufnahme = gibt die reale Umgebung wieder aber eben nur von oben. Diese Variante bildet zum Beispiel auch nicht offizielle Wege ab. Die Zweite Variante “manuelles Eingreifen” erfordert Aufwand (z.B. Vegas, wo sogar die Werbung wie zum Beispiel Beatles Musical usw. passt) oder eben Variante 3 “generierte Welt” was zwar zu schönen Bäumen, Sträuchern, Grasbewuchs führt und wenig Speicherplatz belegt, aber eben nur in den Grundrissen der Realität entspricht.

Letzte Variante kommt sowohl um Mount Whitney, dem Grand Canyon als auch in Yosemite zum Einsatz. Wie die Wanderwege dort aufgezeigt werden ist mir noch nicht ganz klar, aber ich vermute die sind auch generiert und basierend nicht auf Satellitenaufnahmen. Auch Wanderwege sind ja auf Karten verzeichnet. Auf Bergen wiederum sehen die Farbpatches teilweise nach Satellitenaufnahmen aus, die dann aber teilweise fälschlicherweise mit Rasentexturen oder Bäumen / Sträuchern angereichert werden, wo in der Realität keine sind.

Somit wechselt der FS 2020 ständig zwischen sehr hohem Realitätsgrad und vollständiger Fiktion.

Flight Simulator 2020 – Epcot Wold Showcase – Komische Bäume, oder? Typisches Beispiel für aus einer Satellitenaufnahme entstandene 3 Baum Modelle

Weiter nach Yosemite Valley. Im ersten Anlauf war ich mir nicht sicher, ob ich es gefunden habe bzw ob ich richtig bin. Mangels Koordinaten ist das nicht immer so einfach. In dem Kontext hilft die Satellitenkamera deutlich um Ziele zu finden. Im zweiten Anlauf konnte ich dann Half Dome, Visitor Center, Campigplatz vor dem Halfdome usw. bestimmen.

Flight Simulator 2020 – Epcot World Showcase (Japan, Marokko)

Navigation?

Abseits von drei vorgegeben Karten und vorgegeben Zielen kann man die Navigation quasi vergessen. Man kann nur sehr kompliziert Koordinaten eingeben (z.B. von Google ermitteln und dann im Suchfeld eingeben – nähe Mount Everest z.B. 27°58’57.0″N 86°54’59.0″E – da der FS aber gerne abstürzt, wenn man raustabt sollte man die Koordinaten vorher im Zwischenspeicher haben) und Landmarks wie Mt. Whitney oder Yosemite Valley gibt es schlicht nicht als Text oder Marker auf der Karte.

Somit muss man entweder mit vom Spiel vorgegeben Zielen navigieren oder auf Sicht (Straßen, Flüsse, Seen, Berge). Letzteres (Seen) habe ich sowohl für die Identifikation von Yosemite als auch Mount Whitney genutzt.

Flight Simulator 2020 – Magic Kingdom von oben ohne 3D Modelle

Man kann lediglich von (zugegebenermaßen) vielen vorgegeben Punkten zu vorgegebenen anderen Punkten fliegen (also A / B). Mehr geht nicht. Der ist erstaunlich wenig für einen Simulator. Zumal es sicher kein großer Aufwand gewesen wäre Koordinaten zu erlauben oder Punkte auf der Karte anzuklicken und Zwischenwegpunkte zu setzen. Somit wirkt der Flight Simulator 2020 recht schnell hingeschustert.

Grafikhype trifft auf Realität

Nachdem Yosemite und Mt. Whitney eher enttäuschend waren, kann ich schon mal ein Fazit ziehen: Dort wo es keine 3D Modelle gibt sollte man deutlich Abstand vom Boden halten. Sonst sieht die Grafik nicht gut aus. Das sorgt auch dafür, dass die weichgespülten Berge weit weniger auffallen.

Flight Simulator 2020 – Magic Kingdom von oben mit 3D Modellen

Naturexpeditionen streiche ich also komplett von der Feature Liste des FS 2020.

Somit lag als nächstes ein Besuch in Disney World Florida nahe. Die Parks kenne ich gut und wenn es irgendwo 3D Objekte gibt, dann wohl in den meistbesuchten Freizeitparks der Welt, oder?

Für die 3D Objekte benötigt es übrigens die oben bereits erwähnte gute Internetverbindung. Ohne Internetstreaming kann man zwar um die ganze Welt fliegen! aber abseits von landschaftlichen Erhebungen ist die Welt flach. Gebäude sind nur eine Textur auf dem Boden.

Flight Simulator 2020 – Magic Kingdom

Erst das Streaming versieht die Welt mit 3D Objekten. Der erste Flug über Epcot – durchaus beeindruckend. Zu nah ran gehen sollte man aber nicht. Selbst mit 3D Objekten empfiehlt sich eine Mindesthöhe von 1000 Fuß. Ansonsten wird es unschön. Das ist übrigens auch bei der Grafikeinstellung Ultra so, die sorgt zwar für schöneres Wasser und bessere Beleuchtung aber am Boden wird dadurch nichts besser. Die Qualität der Satellitenaufnahmen ist aber der größte Schwachpunkt in Bezug auf Tiefflug.

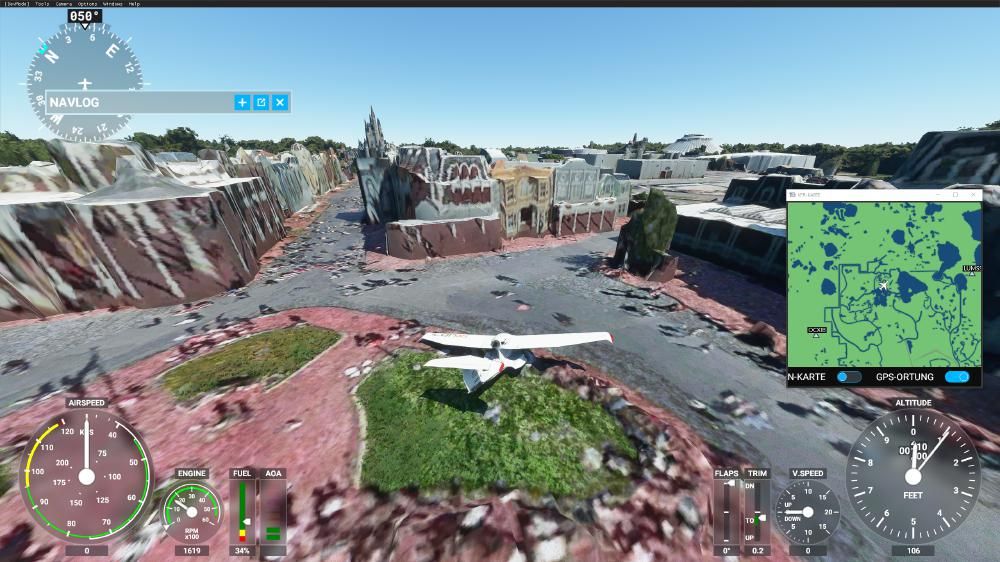

Flight Simulator 2020 – Magic Kingdom Main Street. Da schüttelt es einen, oder?

In Magic Kingdom hat die Internetverbindung zwischendurch nicht für die 3D Modelle gereicht und dann zeigt der FS 2020 sich von seiner richtig hässlichen Seite. Ich wusste, dass ich mich über Magic Kingdom befinde aber wirklich erkennen kann man es ohne 3D Modelle kaum.

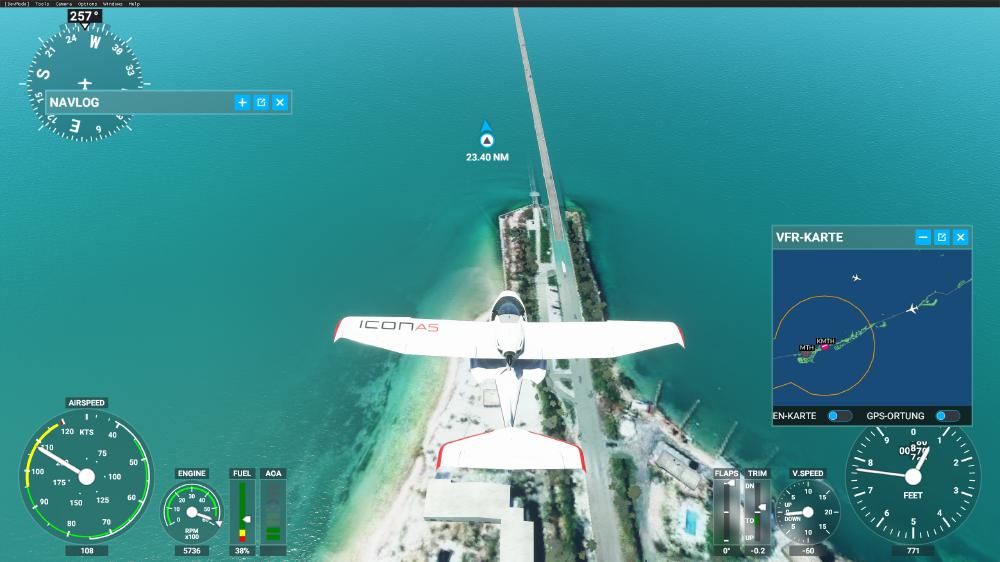

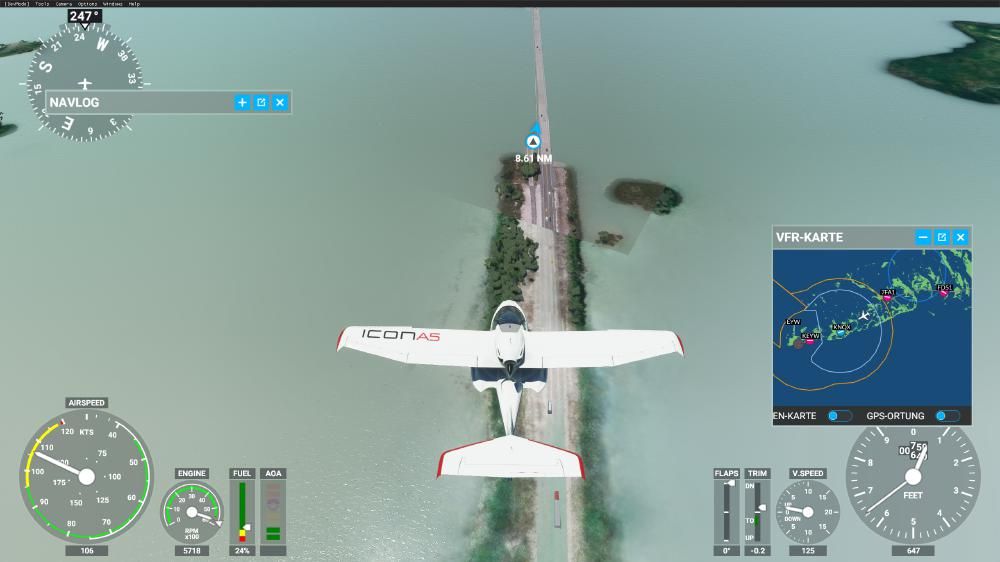

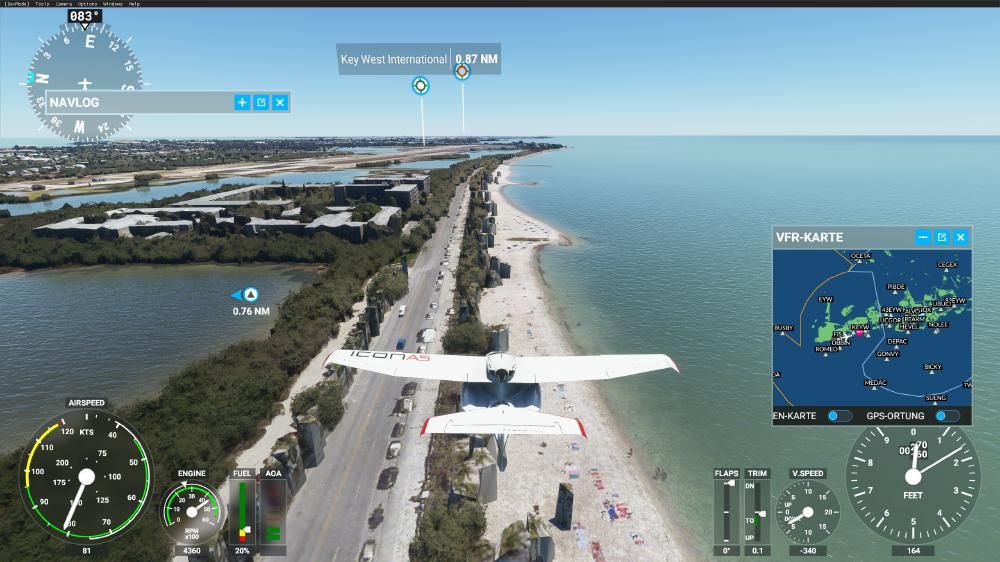

Florida Keys

Im nächsten Schritt habe ich dann doch noch mal an anderer Stelle versucht, ob der FS 2020 Landschaft nicht doch kann und bin noch mal enttäuscht worden. Der Flug über die Florida Keys sollte eigentlich wunderschön sein. Abseits von matschigen Texturen und etwas Strandflair hielt sich die Schönheit aber in Grenzen. Die Anzahl der Fehler in dieser Region ist aber wirklich beeindruckend.

Flight Simulator 2020 – Florida Keys Der alte Highway versinkt im Meer (links neben dem neuen Highway)

Der alte Highway an den Florida Keys wurde übrigens vollständig entfernt. Das Problem was die Entwickler hatten, war das Wasseraufnahmen vom Satelliten statisch sind und das bescheiden aussieht. Somit müssen sie Satellitenwasser durch Simulationswasser ersetzen. Dieser Ersetzung fällt eben allem zum Opfer was nicht Land ist. Den alten Highway sieht man nun immer wieder ins Wasser gehen und aus dem Wasser kommen aber als Straße existiert er nicht.

An einigen Stellen wurde das Wasser auch nicht ersetzt. Dort bekommt man dann statische Bote mit statischen Schaumkronen im Wasser zu sehen. Insgesamt war die Reise entlang der Keys eher ernüchternd (ganz im Gegensatz zum realen Erlebnis). Was ich allerdings auf dem Weg erfahren habe, dass es unterdessen Kreuzfahrtschiffanleger in Key West gibt, die es bei meinem letzten Besuch noch nicht gab.

Wasserfälle kann das Spiel übrigens überhaupt nicht darstellen. Die Niagara Fälle sehen einfach potthässlich aus. Zum Glück bin ich nicht selbst hin geflogen, sondern habe mir ein Video angesehen.

Flight Simulator 2020 – Florida Keys Generiert vs. Satellit

Da wären wir übrigens beim Punkt Aktualität. Wie auch bei Google sind die Satellitenaufnahmen teilweise mehrere Jahre alt. Wenn man Disney überfliegt bekommt man also einen mehrere Jahre alten Stand geboten. Sehr schön kann man das an den Hollywood Studios erkennen. Den Disney Hut im Park gibt es nicht mehr. Den Star Wars Bereich und auch den Toy Story Bereich gibt es im FS 2020 nicht. Beides ist aber schon seit mehreren Jahren im Bau oder beendet (Toy Story Land wurde 2018 eröffnet, die Aufnahmen sind also mindestens von 2017 oder älter).

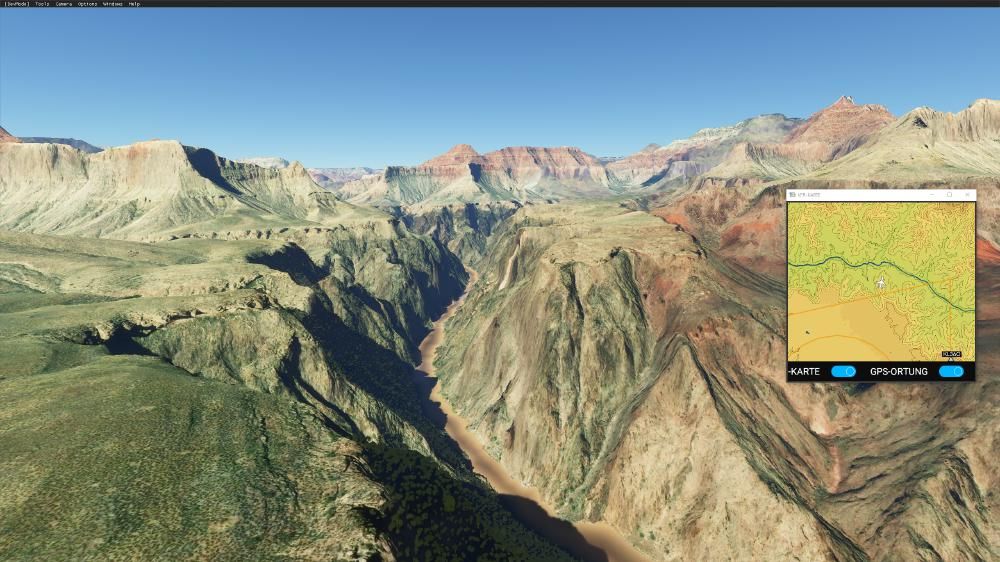

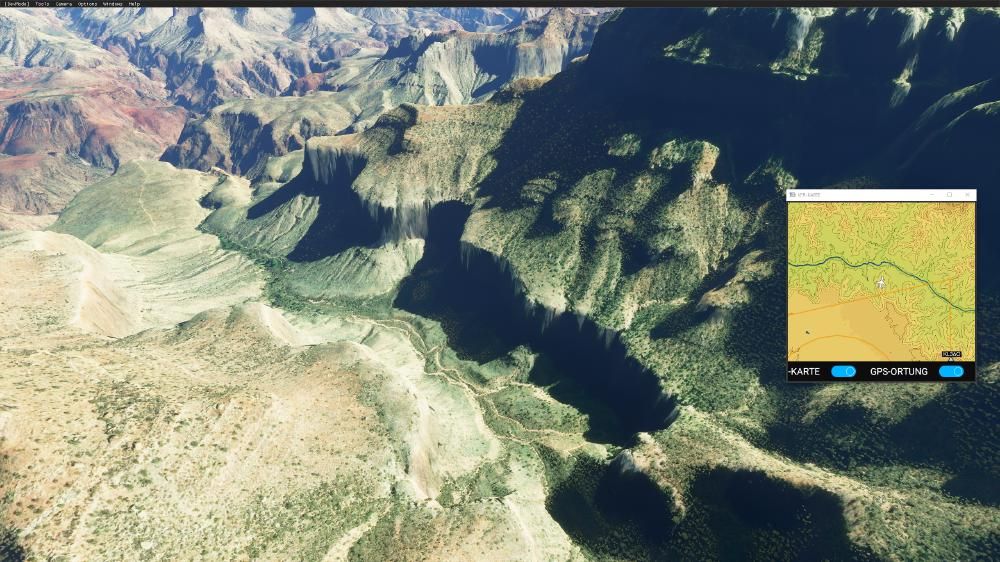

Grand Canyon

In wenig bewaldeten Regionen lassen sich sogar Wanderwege bestimmen. Ich habe mir am Grand Canyon den Weg vom South Kaibab Trailhead zurück zum Bright Angel Trailhead angesehen auch da habe ich mich geärgert, dass ich letztes Jahr am Tip Off Point gestoppt habe. Es waren zwar 40°C und ich hatte nur noch begrenzt Wasser aber der Aufstieg war dann viel einfacher als befürchtet (ja, es war die vernünftige Entscheidung aber das ist ja nicht immer die beste).

FS 2020 – Grand Canyon Fotospotcheck

Ich hätte ich mindestens zum Colorado runter gehen sollen oder im Optimalfall den zweiten Weg zum Bright Angel Trailhead wieder hoch. Wenn ich das richtig sehe, wäre ich wohl auch an das Wasser im Colorado ran gekommen und hätte auffüllen können (siehe Screenshot oben). Man muss allerdings vorsichtig sein, was im Flight Simulator wie flaches Terrain aussieht kann extrem felsig sein (Stichwort Weichspülen von Bergen). Das passiert selbst an Bergen wie dem Everest, die abseits ihrer Höhe aus der Nähe alle so gerundet aussehen, als wenn es sanfte Hügel wären. Davon sollte man sich nicht täuschen lassen.

FS 2020 – Grand Canyon Fotospotcheck

Solche Dinge kann man sich mit dem FS 2020 super anschauen, vor allem in wenig bewaldeten Regionen. Es ist sogar möglich im Grand Canyon zu schauen welche Fotospots gut sind (die Details und Schönheit der Landschaft kommt zwar nicht rüber aber zumindest was man von einem Ort in etwa sehen kann).

FS 2020 – Grand Canyon Wanderwegcheck Bright Angel Trail

Im Grand Canyon klappt das hervorragend und hat mir gezeigt, dass ich da irgendwann noch mal hin muss. 😉 Dann mit zwei Tagen Zeit, dann geht es ganz gemütlich runter und wieder hoch. Das geht auch in einem Tag aber ist dann schon etwas anstrengender und man muss recht früh los.

FS 2020 – Grand Canyon Fotospotcheck – nicht so schlecht, oder? Kann man mal hinwandern

Ich habe von Yosemite ein paar Beispiele von realem Foto und Screenshot in FS 2020 angefügt. Zumindest die Perspektive kann man damit ziemlich genau nachstellen.

Tops und Flops

Flight Simulator 2020 – Christo Statue von hinten – totaler fail – von vorne sieht sie übrigens top aus! – Die Treppen oben sind alle frei schwebend in der Luft

Flight Simulator 2020 – New York die Freiheitsstatue top

Flight Simulator 2020 – New York Central Railroad of New Jersey Terminal eher flop (Ellis Island sieht übrigens noch schlimmer aus)

Flight Simulator 2020 – New York One World Trade Center eher flop (die Form passt, die Textur ist schlecht)

Flight Simulator 2020 – New York Brooklyn Bridge eher top

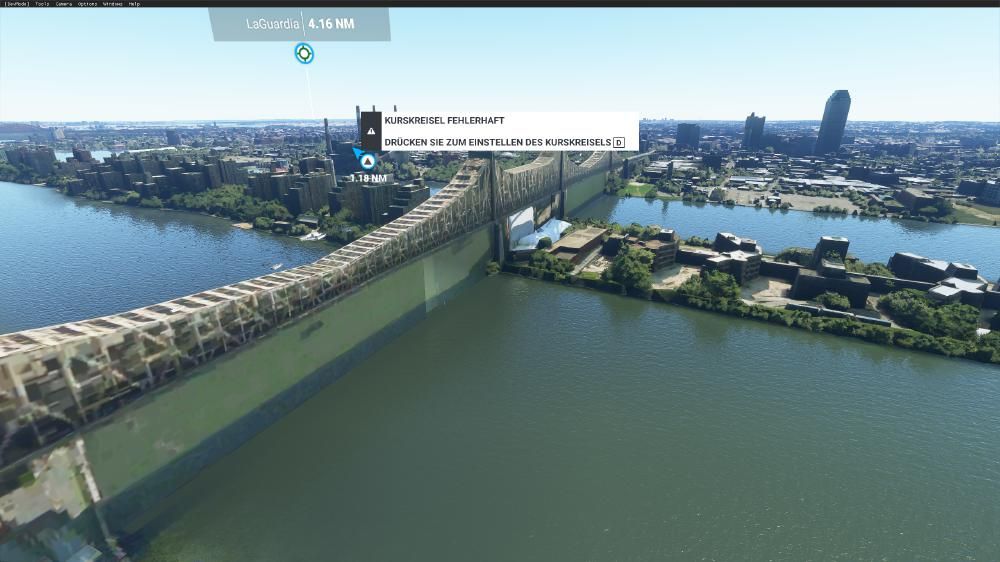

Flight Simulator 2020 – New York Queensboro Bridge das spottet jeder Beschreibung fail

Flight Simulator 2020 – New York das soll der Flugzeugträger sein. Ok, muss man wissen – flop

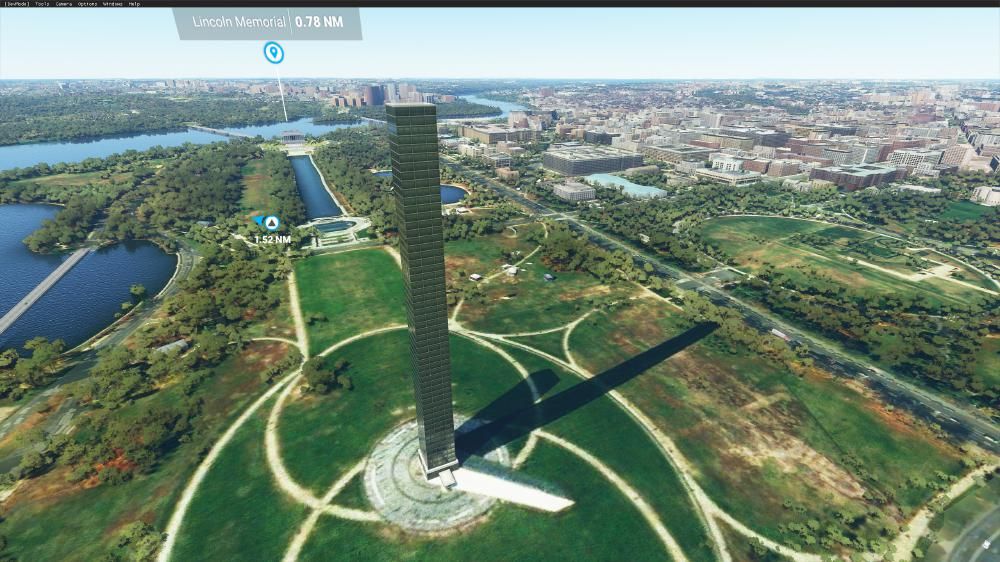

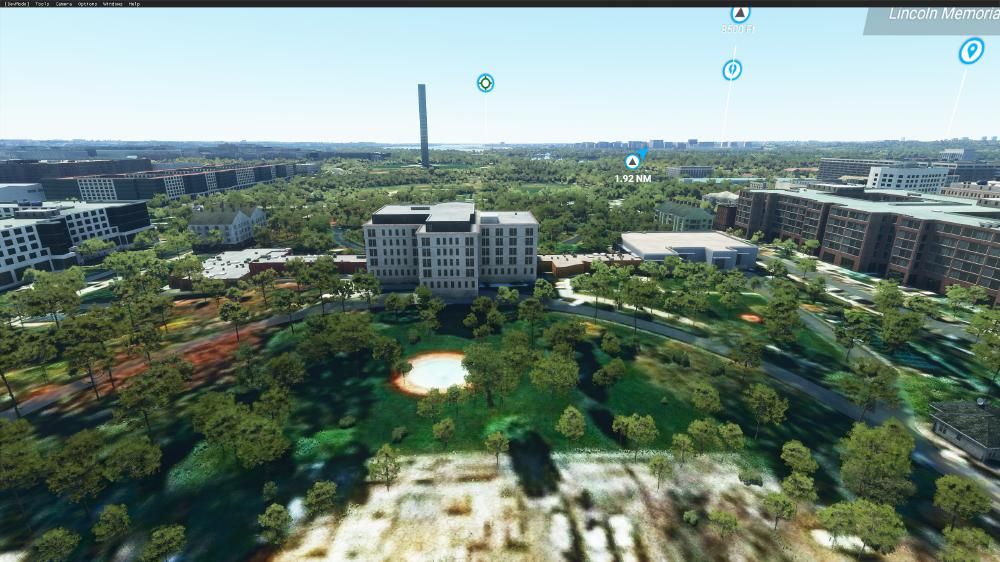

Flight Simulator 2020 – Washington – Urks sieht das gruselig aus. Das soll der Obelisk in Washington sein. Unten sieht man den echten Schatten aus der Satellitenaufnahme, das echte Objekt und das Hochhaus was daraus geworden ist mit eigenem Schatten. Das passiert bei automatisch generierten Objekten – fail++

Flight Simulator 2020 – Washington – fail

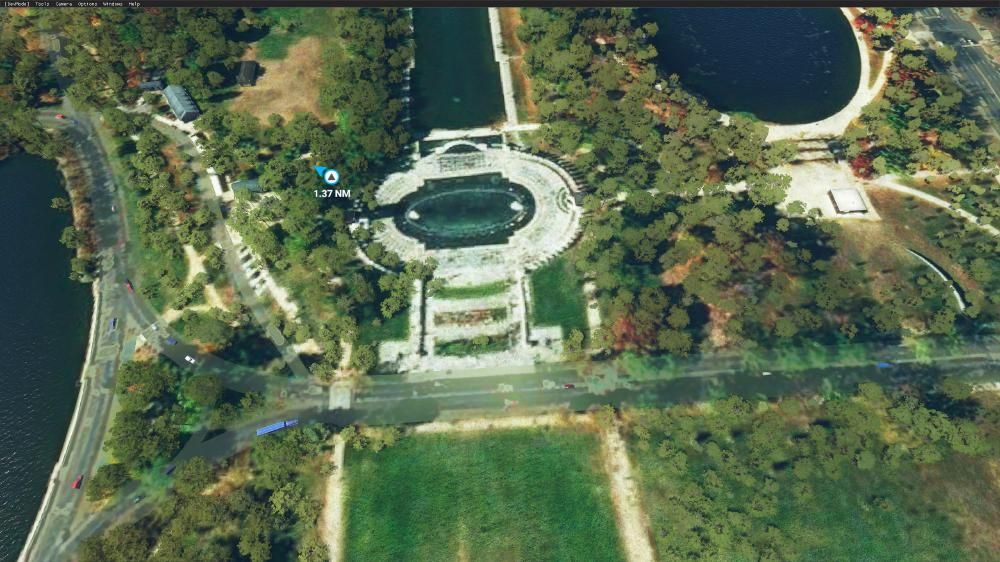

Flight Simulator 2020 – Washington Lincoln Memorial – top

Flight Simulator 2020 – Washington Lincoln Memorial – top

Flight Simulator 2020 – Washington White House – fail++

Flight Simulator 2020 – Sydney Opera House – Wow!

Flight Simulator 2020 – Sydney Harbour Bridge – Ernsthaft? Mega fail

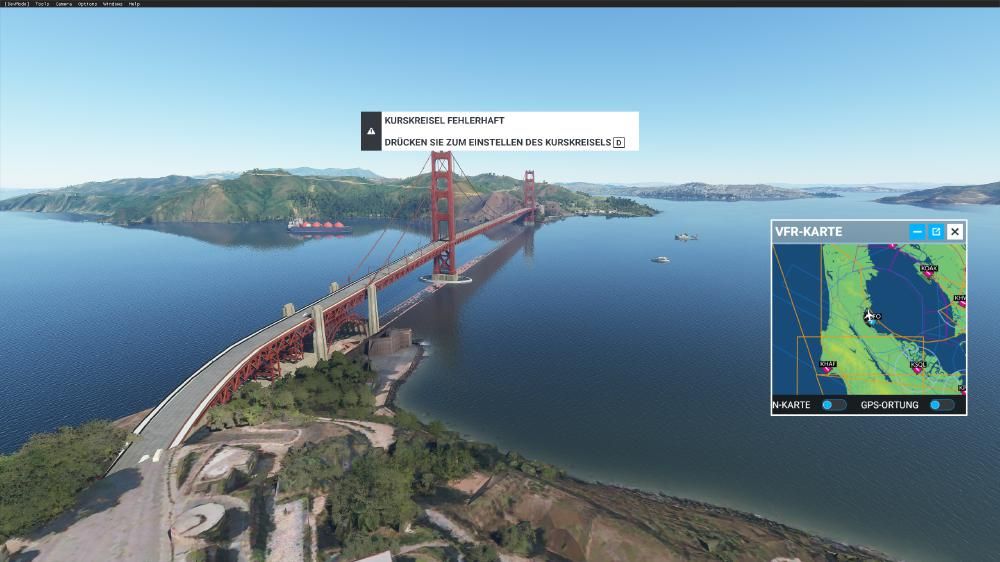

Flight Simulator 2020 – San Francisco Golden Gate – top

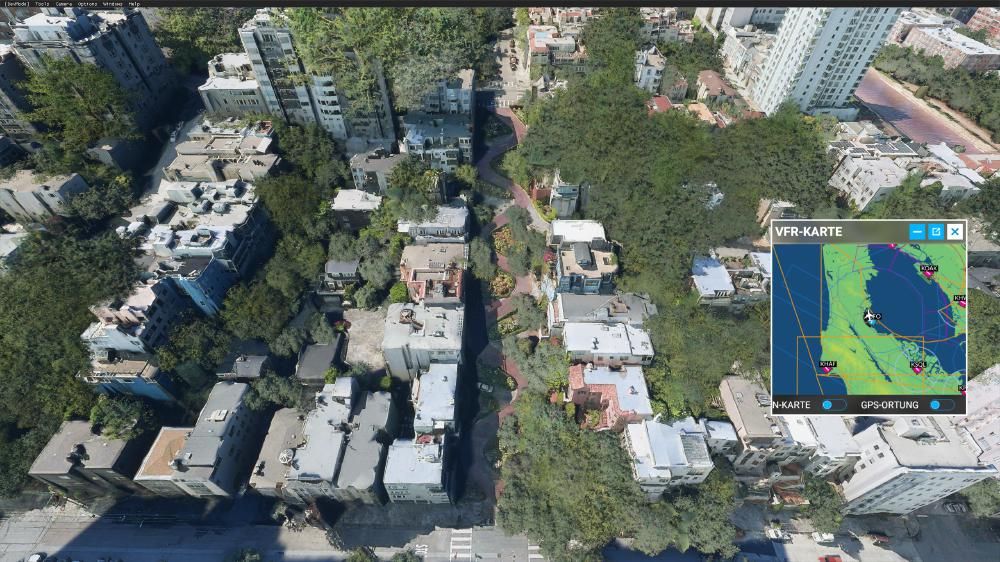

Flight Simulator 2020 – Sydney Lobard Street – eher top

Flight Simulator 2020 – Istanbul – Hups, ist da wer nicht fotogen?

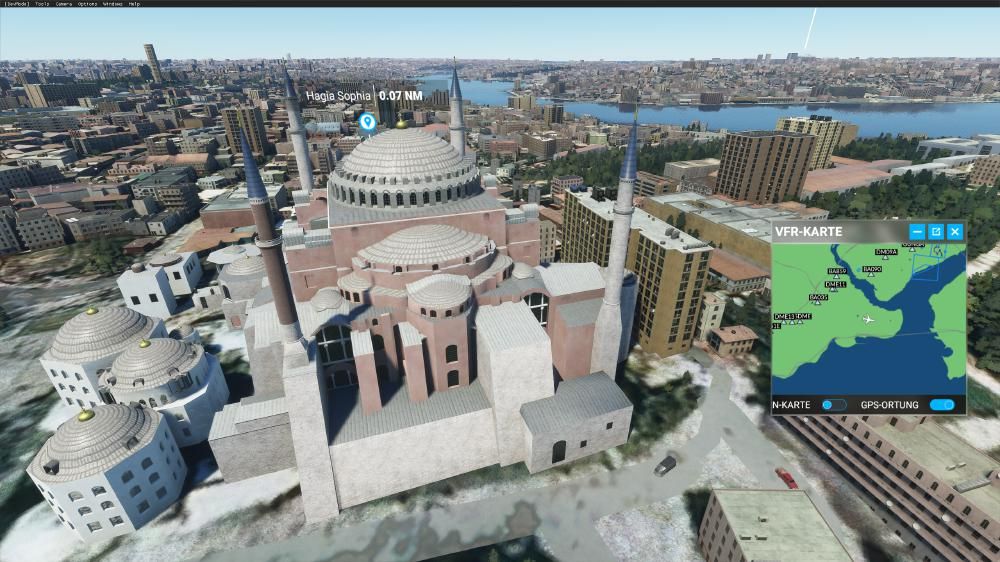

Flight Simulator 2020 – Istanbul Hagia Sophia – top

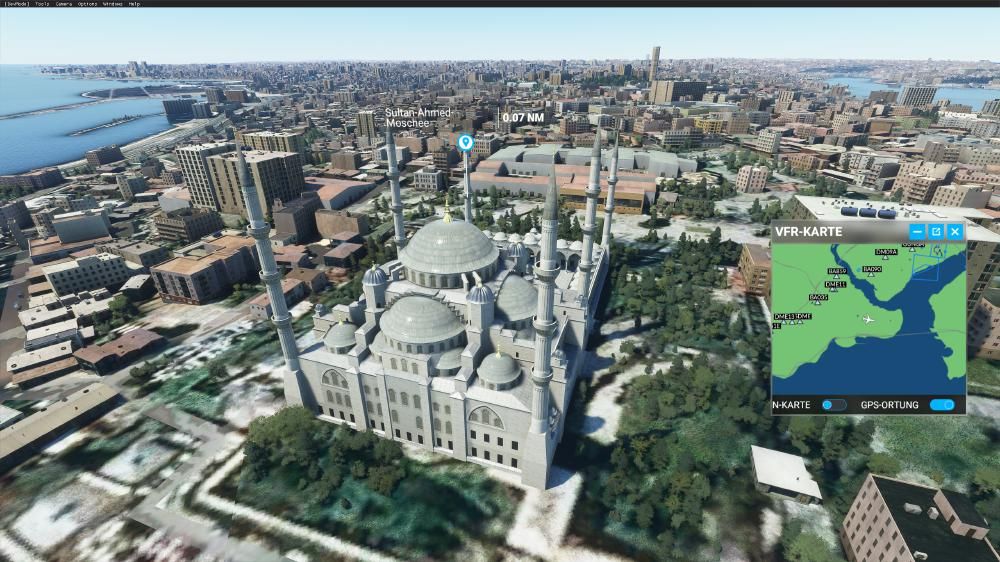

Flight Simulator 2020 – Sultan Ahmed Moschee – top

Flight Simulator 2020 – Kairo Pyramiden – top zumindest optisch, da ich noch nicht dort war kann ich die Übereinstimmung mit der Realität nicht bewerten

Herausforderungen und Spielmodi

Was kann man denn im FS eigentlich machen? Nicht viel und doch alles lautet die Antwort. Nicht viel, weil es abseits der Flugschule (die übrigens rein das Fliegen betrachtet und nichts anderes. Keine Kommunikation, kein Auftanken, kein Navigieren auf dem Flugplatz) nur recht wenig Auswahl gibt.

Auch die diversen Möglichkeiten der Funktionen eines größeren Flugzeugs werden nicht erklärt. Wer also einen Airbus besteigt wird plötzlich mit massenhaft Funktionen konfrontiert, von denen er in der Flugschule im Kleinflugzeug nie etwas gehört hat. Auch Themen wie Treibstoffmix oder andere Einstellungen werden überhaupt nicht behandelt? Ein Nachtflug vergesst es. Ihr werdet schon selbst rausfinden was zu beachten ist.

Flight Simulator 2020 – Key West Versunkene Schiffe und Gebäude

Es gibt 3 vorgegeben Flüge durch die Landschaft (oben hatten ich bereits festgestellt, dass die Landschaftsflüge eher durchwachsen aussehen).

Ansonsten gibt es einige Landeherausforderungen auf einigen herausfordernden Flughäfen. Das hat man recht schnell abgearbeitet und ansonsten gibt es nur noch den Freiflugmodus, bei dem man sich um die ganze Welt bewegen kann. Es sind weltweit auch sehr sehr kleine Flugfelder vorhanden. Man kann im wahrsten Sinne irgendwo im nirgendwo starten.

Flight Simulator 2020 – Florida Keys

Das eigentliche Potenzial das der FS zeigt ist die ganze Welt auf verhältnismäßig hohem Detaillevel zu simulieren (man stelle sich mal die ganze Welt mit Modellen wie dem Sydney Opera House oder dem Licoln Memorial vor).

An vielen Stellen wie z.B. bei Disney hat man Lust zu landen und mehr ins Detail zu gehen (wobei der FS dann gänzlich versagt, wenn die Modelle nicht manuell erzeugt wurden, gut dafür ist er auch nicht gemacht). Das wäre aber wirklich spannend. Wenn man sich in einem detaillierten Weltmodell bewegen kann und zwar egal ob mit Flugzeug, Auto, Zug oder wie auch immer.

Wie man sieht ist die Grundlage da, bis das aber wirklich auf “fotorealistischem” Niveau geht werden wohl noch einige Jahre (Jahrzehnte) ins Land gehen. Oder man muss Fotorealismus mit einem Mindestabstand von mehreren tausend Fuß definieren.

In so einem Weltmodell könnte man dann aber problemlos alle Arten von Simulationen abbilden. Vom Flight Simulator, über Truck, Train, Landwirtschafts- und sonstige Simulationen.

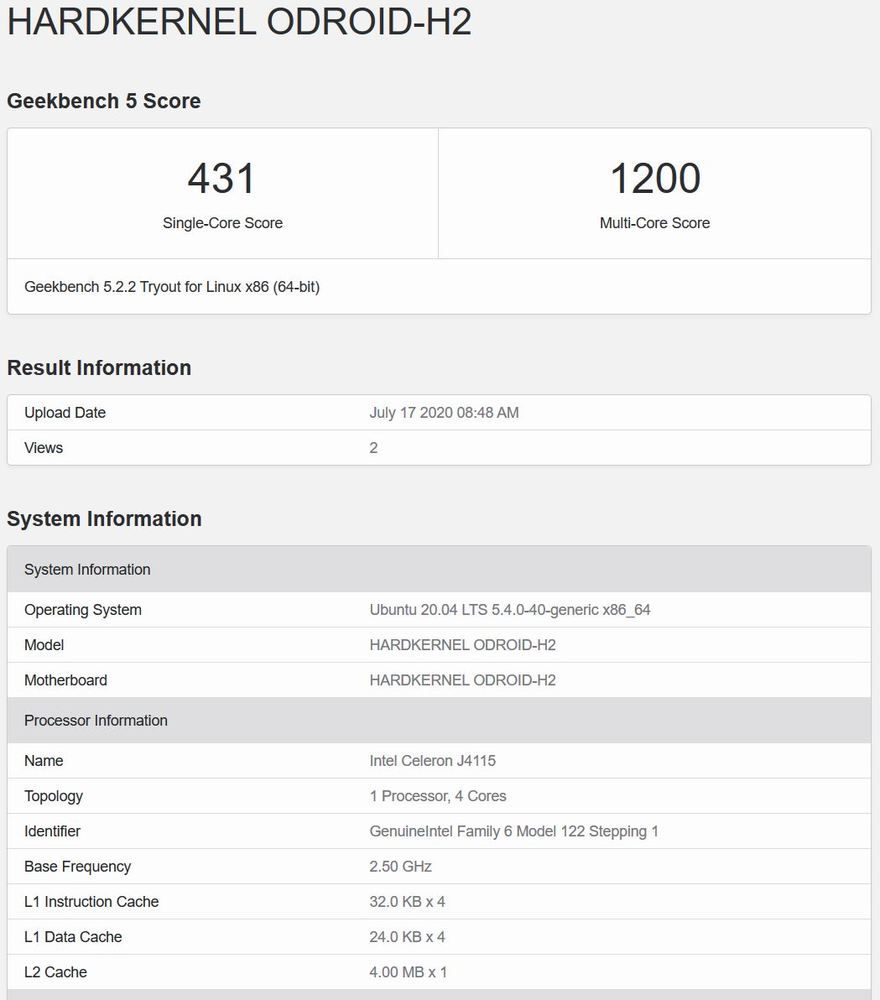

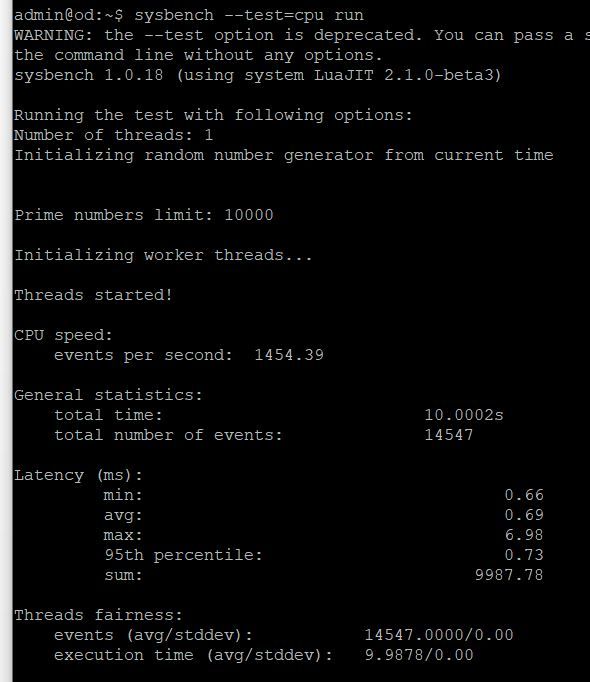

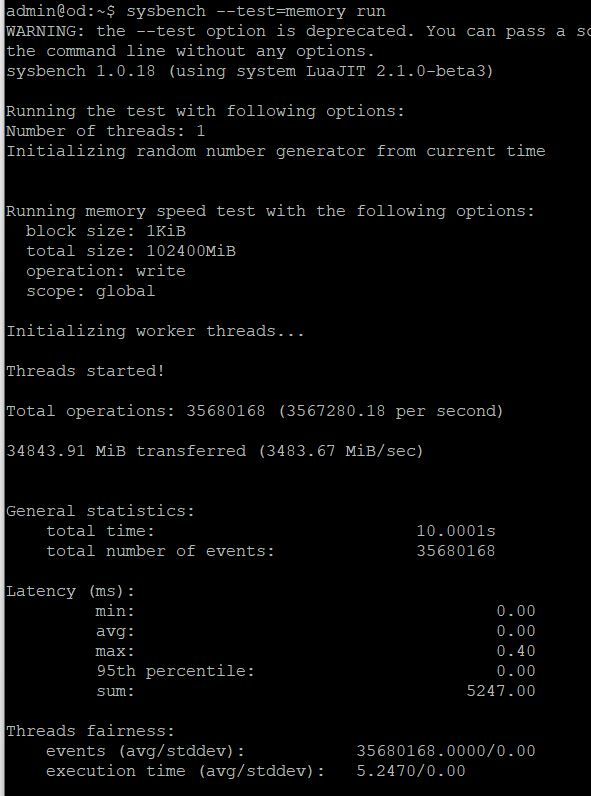

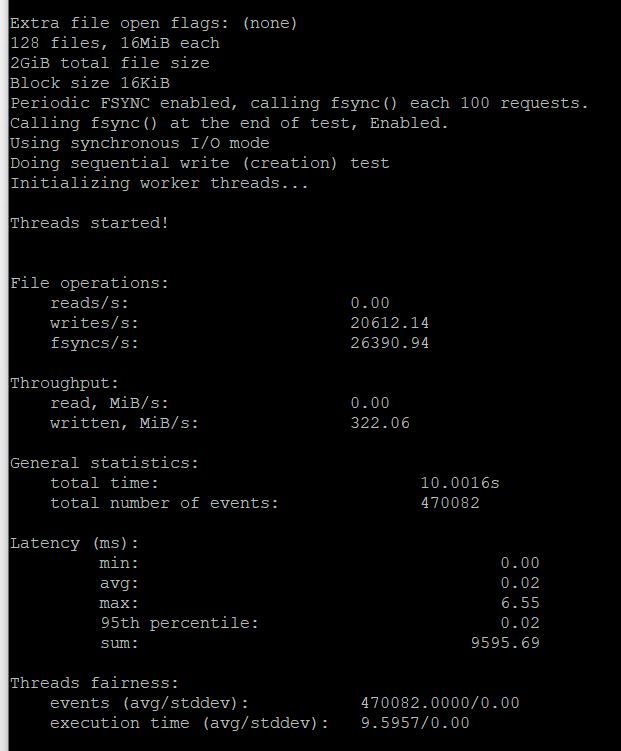

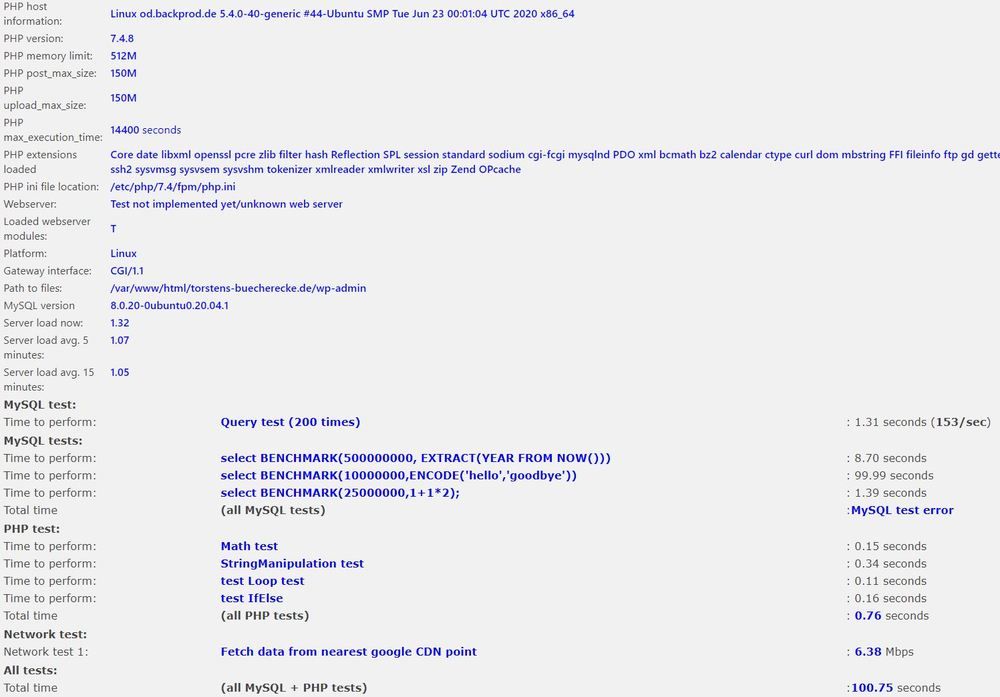

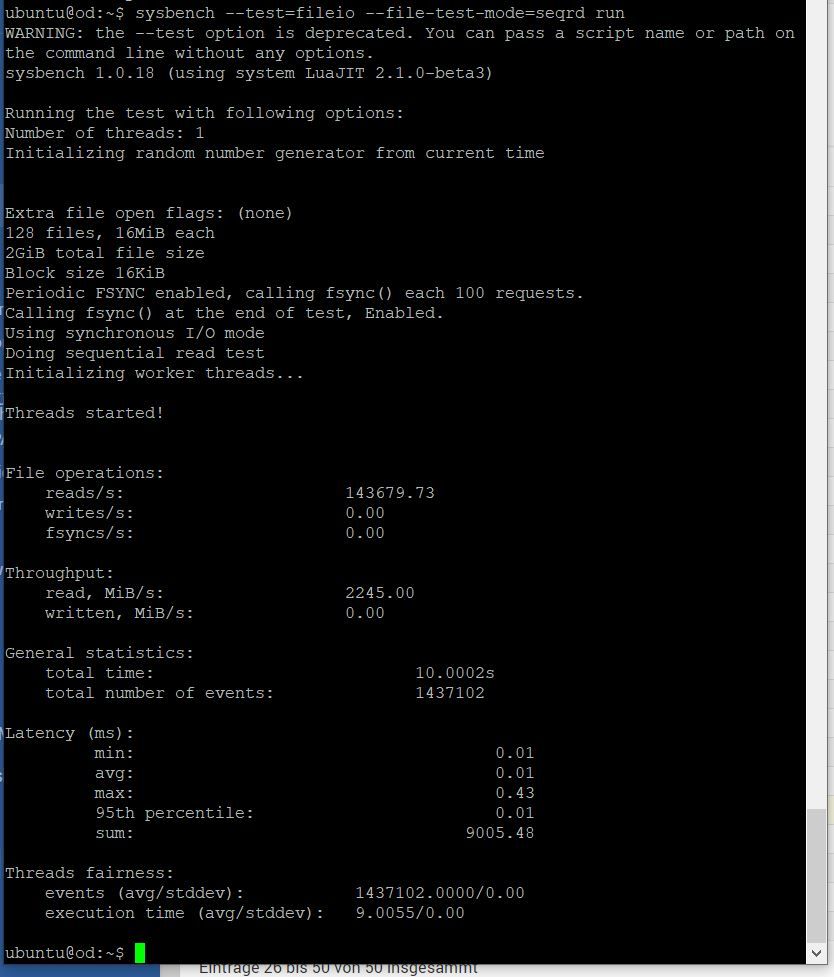

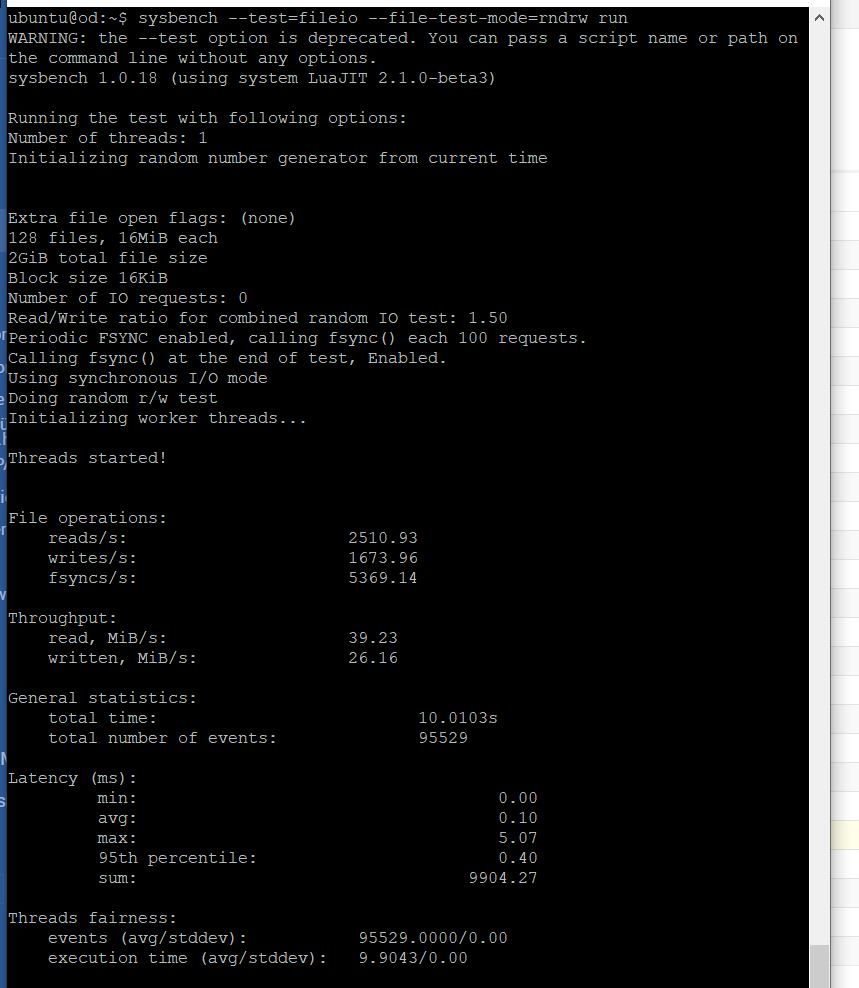

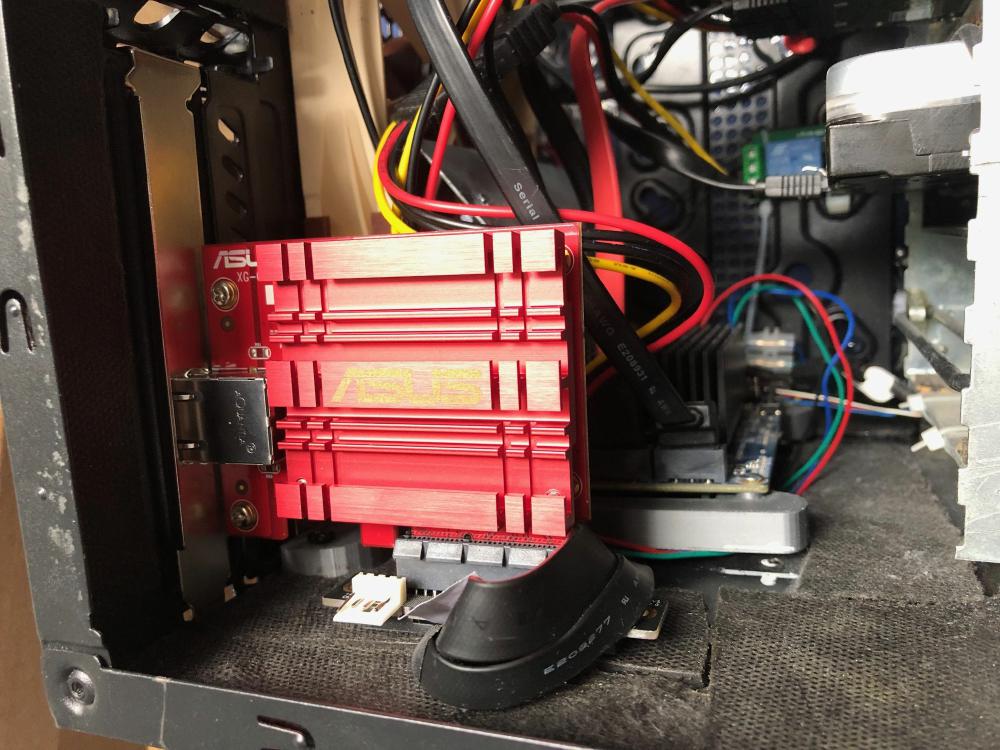

Die Technik

Die Engine ist schlicht nicht optimiert. Sie ist weder für Low Level Apis ausgelegt (nur DX11 statt 12 – DX11 ist 11 Jahre alt!) und auch ansonsten in jeder Hinsicht eher mau. Es werden maximal 6 Kerne unterstützt und die CPU stellt schnell das Limit dar in Auflösungen bis Full HD oder teilweise auch bis 2560 je nach Grafikkarte, obwohl die Kerne nicht mal voll ausgelastet sind. Erst bei hohen Auflösungen im Prinzip ab 4K läuft man mit modernen Grafikkarten ins CPU Limit. Das liegt allerdings daran, dass das die Engine nicht optimiert ist.

Es ist teilweise lustig wie andere Reviews das rechtfertigen. “Es wird die ganze Welt simuliert, da darf es doch etwas dauern / langsamer sein” So ein Quatsch. Jeder Simulator stellt nur den Bereich da, der gerade sichtbar ist und das auch noch in deutlich schlechterer Qualität, desto größer die Entfernung ist. Ob die ganze Welt oder nur eine kleine Region simuliert wird ist vollkommen irrelevant.

Viel relavanter ist zum Beispiel wie viele 3D Modelle z.B. in New York gleichzeitig sichtbar sind.

Die technische Umsetzung ist somit eher schwach und klar kann man das mit mehr Power richten. Man kann auch versuchen mit platten Reifen Auto zu fahren, mit viel PS geht viel. Mit der teuersten und am meisten Strom schluckenden Grafikkarte wird sogar der FS flott.

Der schnöde Mammon

Wo die Preisgestaltung hingeht zeigt Microsoft recht eindeutig. Es gibt bereits jetzt einige Downloadcontents, die alle maßlos überteuert sind. Ein Upgrade von der Standardversion auf die größeren Versionen? In etwa 100% teurer, als wenn man sie direkt erwirbt. Im Prinzip kann man das Spiel auch gleich neu kaufen, viel teurer ist es nicht. Ein weiteres Flugzeug 30€ oder ein Flughafen 20€ und mehr. Wohlgemerkt wir reden hier von EINEM Flughafen / Flugzeug.

Flight Simulator 2020 – Landen in Key West? Besser nicht. Haus und Baum sind unterhalb der Straße platziert.

In Zukunft wird man also vermutlich von mittelmäßigem Content zu Unsummen von Geld überschwemmt werden. Das ist aus meiner Sicht besonders ein Thema weil die enthaltenen Flugmodi abseits des Freiflugs von einem vorgesehenen Punkt A zu einem vorgesehen Punkt B sehr überschaubar sind.

Das Werkzeug für Fotografen?

Ich prophezeie, dass der Flight Simulator 2020 ein unverzichtbares Werkzeug für Fotografen wird (vielleicht ein Geheimtip). Man kann schnell mal an die entlegensten Orte, an Fotospots reisen und schauen was man aus einer bestimmten Perspektive sieht (sogar mit simuliertem Sonnenstand zu einem bestimmten Tag / Uhrzeit). Ich glaube es gibt nichts was das bisher auch nur ansatzweise so bequem erledigt. Das ersetzt natürlich keineswegs das fotografische Auge aber man erkennt auch, dass sich manche Fotospots einfach viel eher anbieten als andere.

Ob nun Skylines, Luftaufnahmen oder an irgendwelchen Fotospots im Grand Canyon oder Yosemite. Man kann ruck zuck sehen was man aus der Perspektive in etwa sehen kann. Ggf. im weg stehende Bäume usw kann man natürlich nicht berücksichtigen aber Berge und andere Prägnante Objekte passen erstaunlich genau.

Lediglich die Navigation ist in dem Kontext wieder ein Problem. Manchmal dürfte es erst gelingen einen bestimmte Stelle zu finden, wenn man schon vor Ort war. Das ist natürlich ziemlich sinnlos. Oder man muss die Koordinaten direkt von z.B. Google kopieren.

Fazit:

Der FS 2020 sorgt für einige wow Erlebnisse. Die Möglichkeit sich weltweit an jeden Ort zu bewegen ist auf dem Detaillevel ziemlich beeindruckend (ich glaube Abseits von Google Earth ist das soweit ich weiß der erste Weltsimulator mit ansatzweise passablem Detaillevel). Anderseits stößt man sehr schnell an die Grenzen, wenn man zu sehr in das Detail geht.

Von kaputten Bäumen, die wir Felsen aussehen, versunkenen Häusern, fliegenden Autos, Baumkronen auf Straßenniveau ist alles dabei. Danach braucht man auch nicht suchen. Das springt einen überall an. Auch Landen ist an Orten mit 3D Objekten an vielen Stellen zum Scheitern verurteilt. Man bleibt an allem möglichen hängen. Das sind keine Einzelfälle. Die Ganze Region der Florida Keys / Key West kämpft mit falschen Höheninformationen (man sollte meinen, wenn sich alles fast auf Meereslevel befindet kann das nicht so schwer sein, aber weit gefehlt, oft stehen Gebäude im Wasser, sind Schiffe versunken oder von Bäumen ragt nur die Krone aus der Straße). Gut, evtl. hat man hier die Klimaerwärmung bereits berücksichtigt. 😉

Auch der Simulationsteil enttäuscht mich partiell. Dabei geht es nicht um die Simulation der Flieger (die kann ich eh nicht beurteilen). Die Flugzeugtypen fliegen sich deutlich unterschiedlich und man bekommt zumindest das Gefühl, dass einiges an Arbeit investiert wurde. Schlimmer finde ich, dass man offenbar nicht mal einen eigenen Kurs setzen kann. Man kann auch nicht extern einen Kurs erstellen und einlesen soweit ich das bisher beurteilen kann.

Ursprünglich hatte ich mal den Ansatz den Pacific Crest Trail (PCT) zu erfliegen aber da der FS 2020 Natur nicht wirklich schön darstellt und offenbar in Naturregionen oft einfach generierte Grafik genutzt wird, statt Satellitenbilder, macht das wenig Sinn, zumal man den Kurs eh nicht eingeben kann.

Flight Simulator 2020 – Airbus. Der Fliegt sich wie ein Panzer

Punkten kann der FS 2020 besonders in bewohnten Gegenden mit vielen Häusern. Ein Flug über Disney, New York oder San Francisco. Da liegt die Stärke des FS 2020. Ein Flug über Landschaft kann je nach Wetter auch so seine Momente haben, wenn man jemals vor Ort war wird man davon aber eher enttäuscht sein. Die Schönheit der Landschaft kann der FS 2020 aufgrund der zermatschten Satellitenaufnahmen und teilweise generierten Welt nicht ansatzweise wiedergeben, von Fotorealismus ist er meilenweit entfernt. Das fängt schon ganz simpel damit an, dass teilweise nicht mal die Texturfarben stimmen und die Struktur auch nicht detailliert ist. Berge sehen z.B. in den Sierras aus wie Hügel und haben weiche Konturen, das ist auch an anderen Stellen so.

Wenn man in großen Höhen fliegt, sieht es durchaus aus wie in einem echten Flugzeug, weil dann die Details keine große Rolle mehr spielen.

Der Hype um das Spiel eh Simulation ist aus meiner Sicht keineswegs berechtigt. Das Problem ist eher, dass es seit langem quasi keine Konkurrenz mehr in dem Genre gibt. Trotzdem ist der FS 2020 wohl der aktuell beste Flugsimulator und wird es mangels Konkurrenz wohl auch lange bleiben.

Um die Eingangsfrage aufzugreifen. Für mich ist der FS weder top noch flop aber er vergibt deutlich Potenzial. Dabei meine ich nicht mal die grafische Darstellung, die noch deutlich Luft nach oben hätte (DX11, ernsthaft in 2020?), sondern eher die nicht vorhandenen Navigationsmöglichkeiten mit GPS Koordinaten oder ganz simpel zum Anklicken auf der Karte, fehlenden Landmarkenbezeichnungen und sehr wenige Flugmodi.

Stand heute würde das Spiel aus meiner Sicht nur als Early Access durchgehen. Soweit ich das beurteilen kann wird sich Microsoft aber jeden weiteren Inhalt mit exorbitant hohen Preisen finanzieren lassen.

Ist das Spiel 65€ oder noch mehr wert? Meiner Meinung nach nein. Ich würde eher sagen 30€. Die ganzen Zusatzinhalte sind eh der reinste Wucher. Wenn sie den ganzen Sierra Nevada Bereich mal als DLC anbieten mit passender Textur und echten Konturen, dann schau ich es mir mal an. Aktuell passt teilweise nicht mal die Farbe. Dort ist nichts grün, das sind Steine und die Formen passen auch nur grob.

Ich bin übrigens gespannt, ob die Darstellung sich im Winter ändert, oder ob es dann bei der hochsommerlichen Darstellung der Sierras bleibt (ich vermute, dass letzteres der Fall ist, man kann aber manuell Schnee aktivieren. Der wird dann einfach über die Landschaft gelegt – dabei ist es egal, ob man gerade am Grand Canyon in der Wüste oder in den Sierras ist).